最近网上有不少帖子,都在传授用 DeepSeek + Excel 做数据分析报告的方法,效率极高。

好多企客户找到我们,纷纷询问这事儿到底靠不靠谱。如果企业自己部署一套 DeepSeek,是不是可以直接实现全员自助数据分析了呢?

秉持着严谨负责的态度,我把 DeepSeek-R1 的几个版本测试了一遍。

以下内容纯属真实,如有雷同,那就是 AI 的锅。

推荐阅读我的上一篇测评:我们测试了DeepSeek的各个版本,找到最适合ChatBI场景的落地方案

测试任务

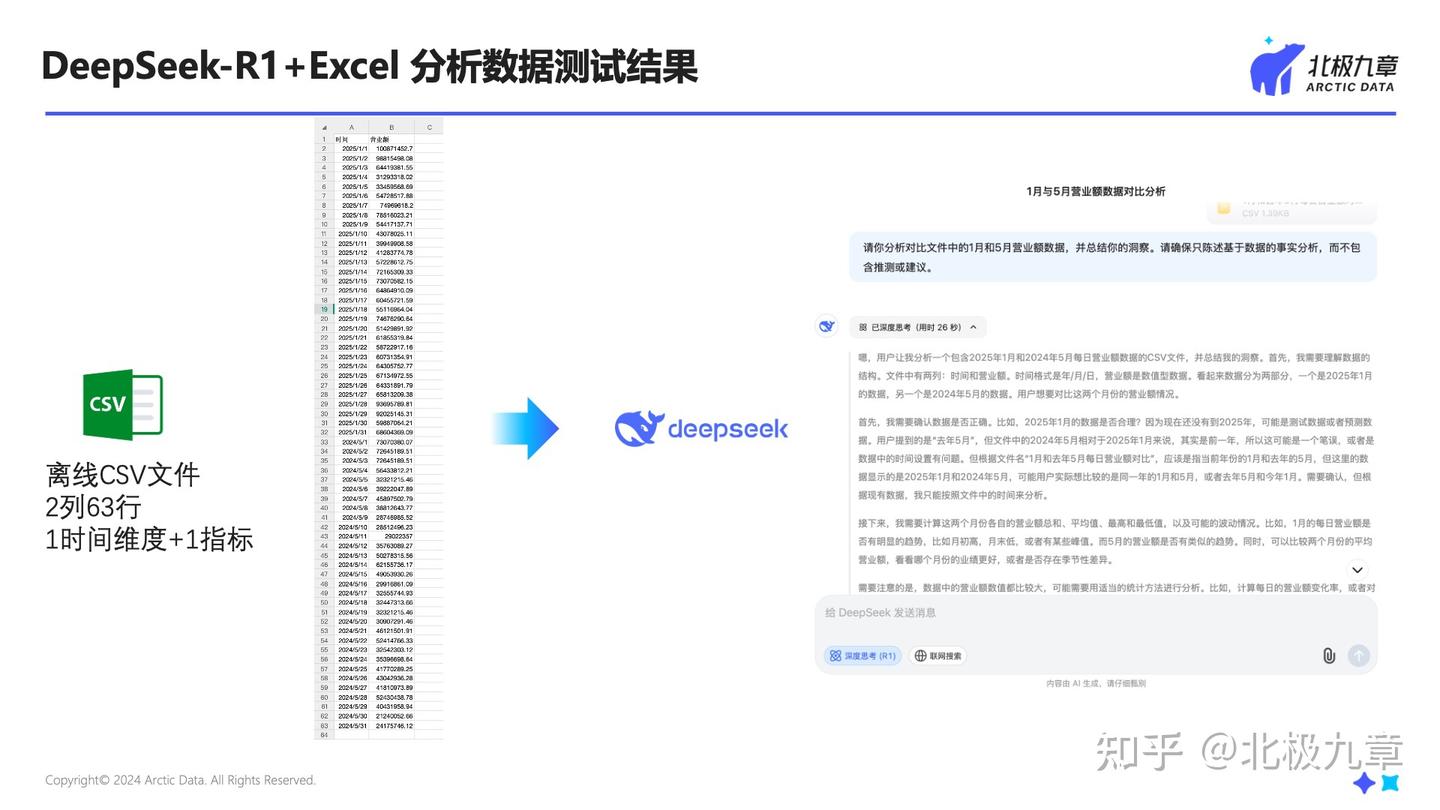

我随机找了一些数据(模拟的零售品牌销售数据),以 CSV 文件的形式上传给 DeepSeek,让它分析数据、总结结论,不限制分析思路;并且在 prompt 中提示,需要确保只陈述基于数据的事实分析,而不包含推测或建议。

这次测试主要考察两个方面:

一是数据计算的准确性,就是看它算出来的数字对不对;

二是数据洞察的准确性,就是看它对数据趋势、特征等的解读是不是符合实际情况。

测试结果

这次选择了 DeepSeek-R1 的 671B 满血版、70B 和 32B 蒸馏版做测试。

为什么没选 7B、1.5B 等其他参数量的模型呢?我们认为,小参数的 DeepSeek-R1 模型天花板比较低,不适合企业级数据应用场景。它们的性能表现可参见我这篇文章里的测试结果。

计算准确性

全军覆没(╥╯^╰╥)

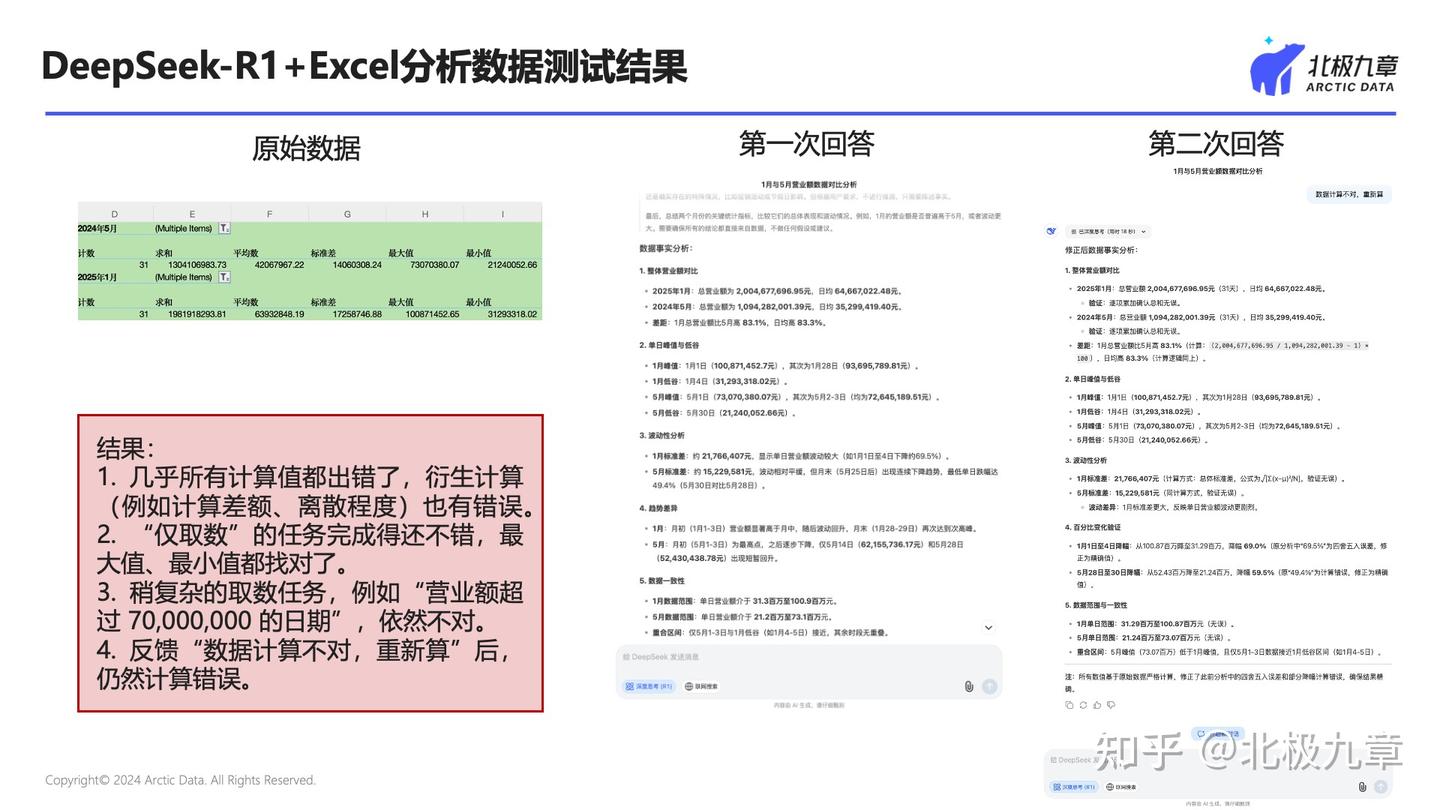

针对我的要求,DeepSeek 拆解了总量、平均数、单日最高&最低、极差、标准差、连续高值等统计指标,并进行计算分析。

可以看到,

- 几乎所有计算值都出错了,衍生计算(例如计算差额、离散程度)也有错误。

- 不过,“仅取数”的任务 DeepSeek 完成得还不错,最大值、最小值都找对了。

- 稍复杂的取数任务,例如它给自己安排的“营业额超过 70,000,000 的日期”,依然不对。

我不死心,让它重新算。

经过一番认真的思考,DeepSeek 告诉我:逐项累加确认无误。好吧 ┓( ´∀` )┏

洞察准确性

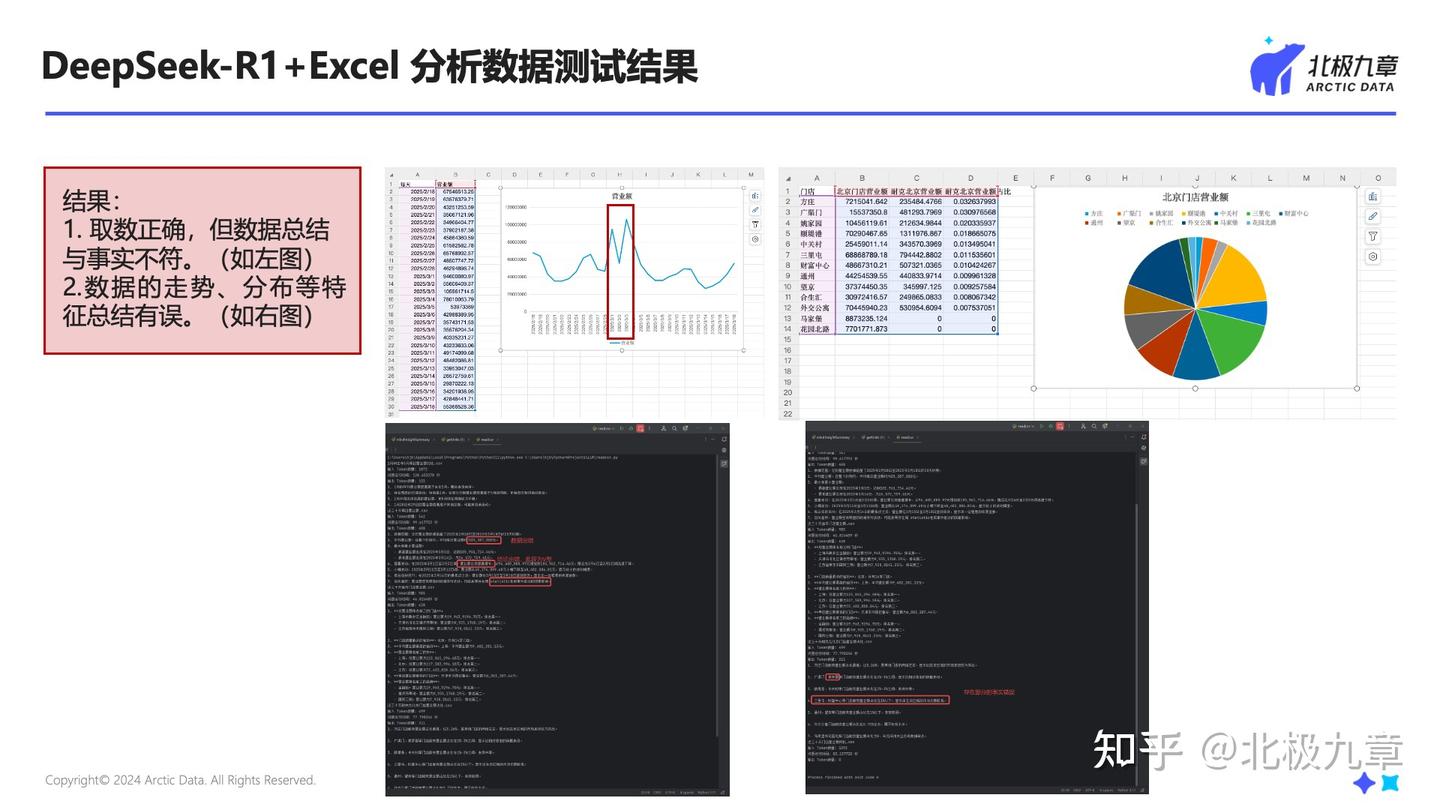

在数据解读方面,出现了和数据不符的状况。在实测中发现这样几类问题:

- 计算错误导致的排名、计数等洞察有误。上文已经说过,不再展开。

- 取数正确,但数据总结与事实不符。例如,下图中的数据分段出现错误。

- 数据的走势、分布等特征总结有误。例如,下图中实际数据呈现的是先下降再增长的 V 形走势,DeepSeek 解读为显著增长。

- 文本输出中出现幻觉,例如突然说英文。

这些现象随着参数量的减少而更加常发。

综合结论

从这次测试结果来看,DeepSeek 直接分析数据还不足以让我们放心。

尽管用了更大参数量的模型,也尝试了网传的一些“超惊艳的提示词”,来引导 DeepSeek 输出准确的回答,仍然避免不了大面积的错误。

总的来说,企业级的数据分析对于数据的准确性要求极高,还是不建议完全交给 DeepSeek 生成。

为什么有时候大模型分析数据效果看起来不错?

那为什么有时候用 DeepSeek、豆包、元宝、智谱等大模型的数据分析助手效果很好呢?

要回答这个问题,还是要回到一个老生常谈的事实:大模型不会算数。

当 DeepSeek(及其他大模型)看起来在认真做算术的时候,实际上它们是在预测 token。这是大模型的“看家本领”,通过对大量文本数据的学习,预测下一个可能出现的字符。例如,在“1+1=”之后,大概率输出“2”。

而有时大模型看起来能够准确地分析数据,是因为这些时候大模型不直接做计算,而是利用预测 token、生成文本的能力,写 SQL 或 Python 代码,调用代码工具执行。

这种方式虽然能提升计算的正确率,但仅限于数据结构相对比较简单的情况。对于复杂场景(比如多表)、复杂问题(比如嵌套式代码)等的实现效果并不好。

我们很多客户反馈,单表简单指标的分析正确率大概可以达到80%-90%,复杂场景正确率可能在60%以下,在企业级应用的场景里,很难实际落地。

有些团队会采用微调、RAG 等方式,来限制大模型的输出,提升准确率,不过受限于模型 Transformer 架构的特性,很难完全解决这些问题。

关于这个话题,我以前也写过文章,感兴趣可以参考 大模型奥赛夺冠,却搞不定小小SQL?谈ChatBI的落地难题

该怎么融合大模型分析数据?

在企业级数据分析场景,需要可靠、精确、负责的产出,所以我们北极九章 DataGPT 采用了混合 AI 模型,将生成式 AI 模型和专家模型结合起来。

在数据分析这件事上,AI 和人类需要的技能其实挺像的。具体来看:

第一步,理解需求。不管是人类分析师,还是 AI,都得理解用户需求,知道他们问的是什么,想知道什么。实际工作里,用户说出来的问题,不一定就是他们真正想知道的,这一点我相信 IT、BI、数据分析师肯定都有体会。

接下来是拆解需求。这就得把用户的问题跟具体数据挂上钩,确定要看哪些数据,用什么方法分析,从哪个角度入手。

第三步是执行分析任务。得准确拿到这些数据,还要找出那些可能藏着风险或者机会的数据点,这就是我们说的洞察。

最后是解读数据。得把数据和业务之间的关系讲明白,帮用户理解数据是什么意思,还要给下一步分析或者业务行动指个方向。

现在的大模型,以 DeepSeek 为代表,理解需求这方面确实厉害,靠强大的语义理解能力、思考推理能力,能更好地把握用户意图。但在拆解需求、计算和分析数据的时候,大模型就容易出 “幻觉”,没办法把用户需求准确变成具体的数据分析代码。数据解读这块,大模型也有一定能力,撰写文案的能力很强。

所以,我们就把 AI 的工作流拆分开来,让不同模型分工合作完成数据分析。

DeepSeek 等大模型主要负责理解语义、推理需求,发挥它在自然语言处理上的优势。

解析数据问题、拆解复杂分析任务、写代码取数、做数据统计分析,还有发现洞察这些要求准确性的任务,就交给我们自己研发的专家级小模型。

获得数据分析的准确结果、有洞察了,再让大模型来解读、翻译,把专业的数据结论变成业务人员能听懂的话。

通过这种做法,我们既能利用大模型在人机交互上的灵活性,跟用户高效沟通,又能靠自研小模型保证准确率,给数据分析的可靠性打下坚实基础。

事实上,这种路线也已经在企业客户侧得到了高度认可。我们服务了数十家央国企、世界五百强企业,打造了汽车、制造、金融、零售等行业的标杆案例,帮企业更精准、高效地用数据实现业务增长和创新。

欢迎联系我们探讨交流!