自从OpenAI和开源大语言模型发布以来,大大小小的分析供应商都在争先恐后地将大模型集成到他们的产品中。他们说:“用人工智能解锁隐藏的洞察力”,“人工智能的力量触手可及”。事实真的是这样吗?

在表面之下,真相往往远没有那么迷人。

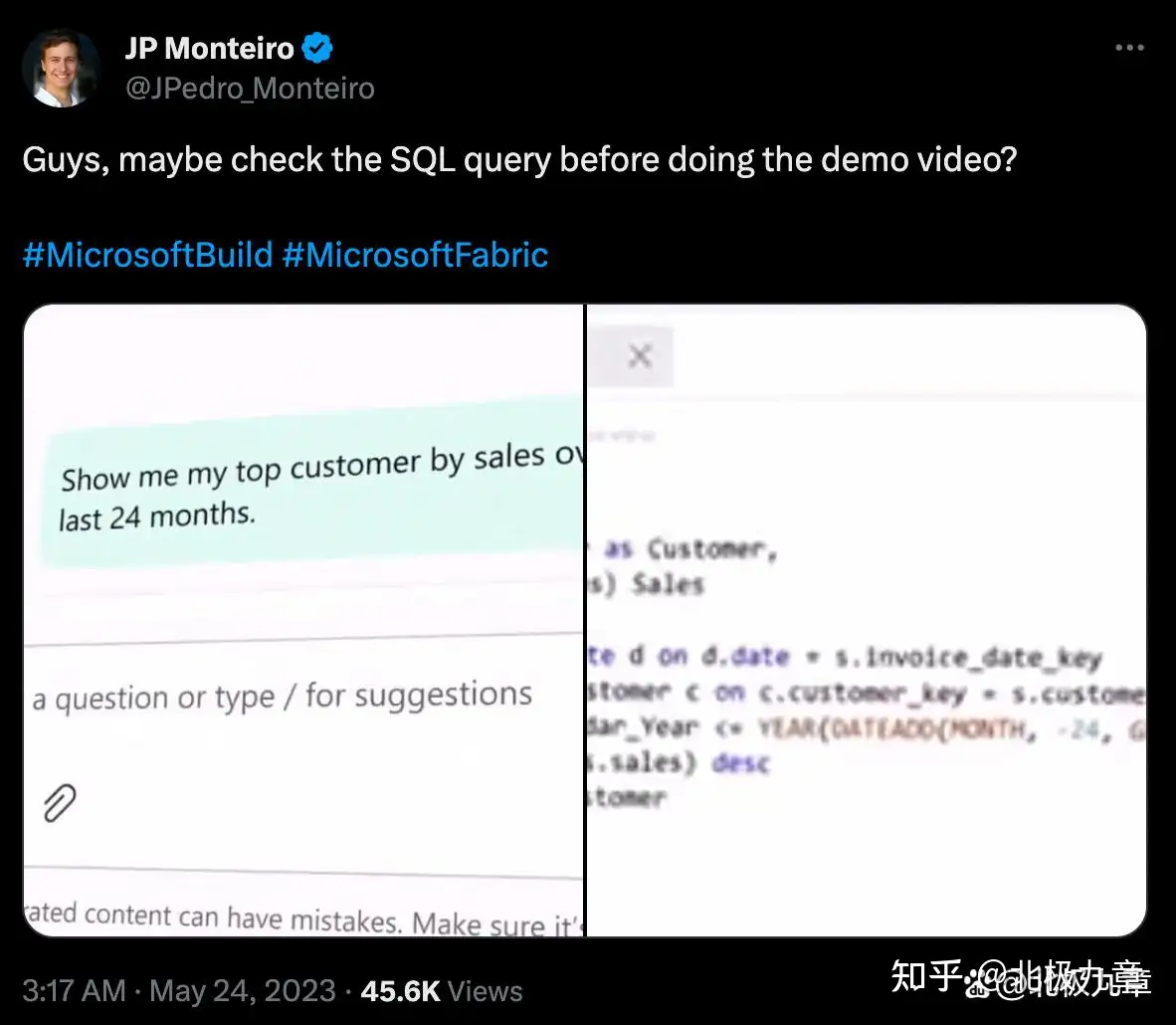

微软在AI数据分析产品Fabric的发布会上就直接翻车。演示中, AI助手虽然能超快速生成SQL代码,但被眼尖的网友发现不正确。

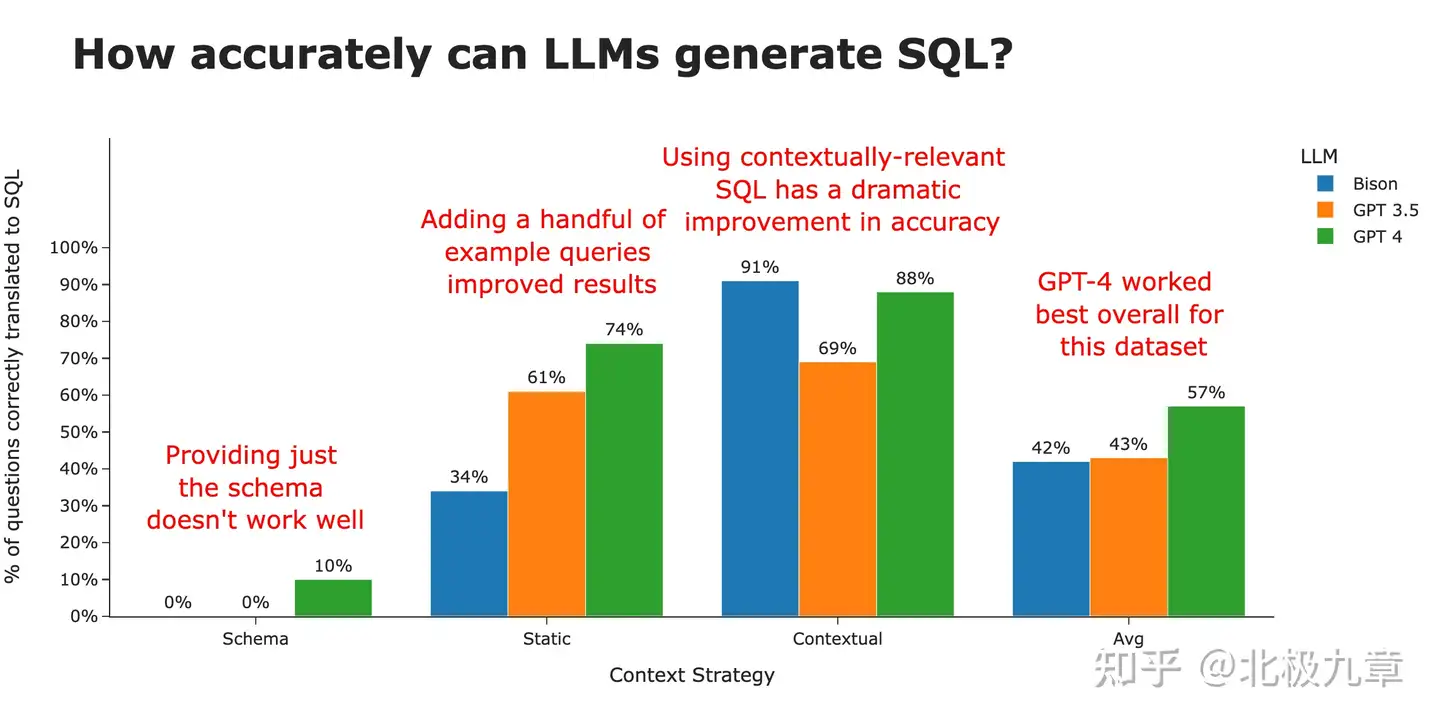

这种情况并不罕见。经过验证测试,大语言模型生成SQL的平均正确率大约是50%-70%。对于懂SQL、能人工检查的分析师来说,这很好,但对于非技术业务用户来说,作为自助分析工具,这完全是一场灾难。

在我们的美好想象中,有了大模型,业务人员就能流畅地和数据对话。但为什么大模型屡屡翻车?我们首先要了解一下在自助数据分析中使用大模型,有哪些要求。

如何回答一个自然语言分析的问题

在能力方面,系统需要理解用户输入的问题,将问题映射到数据库里的维度和指标,甚至创建新的指标。它还需要能够生成适当的查询语句,取出对应的数据,然后可视化输出。此外,系统应该能够分析和解释输出,以向最终用户推荐适当的行动建议。

这些都不是大模型的固有能力,因此,用大模型直接分析数据不像我们希望的那样快速或容易。

大模型分析数据的可靠性

在任何数据分析工具中,可靠性至关重要。 如果工具输出的结果不可靠,用户就有可能获得错误的数据和错误的解释,影响最终的决策——这与AI画图、AI写文章等场景的容忍度是完全不同的。

为了避免这个陷阱,从理解用户的问题到处理和生成分析结果,需要保障稳定性。

大模型分析数据的准确性

第三,由于大语言模型很容易产生幻觉(也就是“胡说八道”),系统还需要确保生成的查询以及分析不是虚构的,而是与真实业务数据紧密结合。而从当前的技术水平来看,还没有办法完全抑制大模型的幻觉。

据测试,GPT生成SQL的准确性约在70%左右(根据问题难度有浮动),然而尴尬的是,作为不懂代码的业务用户,我们不知道哪30%是错误的。也就是说,为了保证准确性,理论上每个AI生成的SQL代码都需要专家人工检查,而这就丧失了用AI提升效率的本意。

大模型分析数据的安全性

此外,数据安全也是企业数据分析的关键要求。

首先,企业数据分析工具需要按用户权限对数据访问的范围进行隔离,大模型暂时无法解决这个问题。

其次,ChatGPT等商业大模型无法私有化部署,而大多数企业都无法承担自研大模型的成本。这也就导致数据泄露风险无法避免。例如三星就已经因内部数据泄露而在内部禁止使用ChatGPT。

数据分析如何应用大语言模型?

大模型在能力、可靠性、准确性和安全性方面有难以逾越的鸿沟,也并不是说大模型在数据分析领域不能用,而是有其独特的力量。

正如我们已经熟知的,大语言模型在语义理解、文本生成、逻辑推理、海量知识等方面表现力极佳,因此在数据分析场景,大模型适合快速总结复杂的分析结果,把数据洞察“翻译”成业务用户能看懂的语言,甚至做进一步的启发式解读。

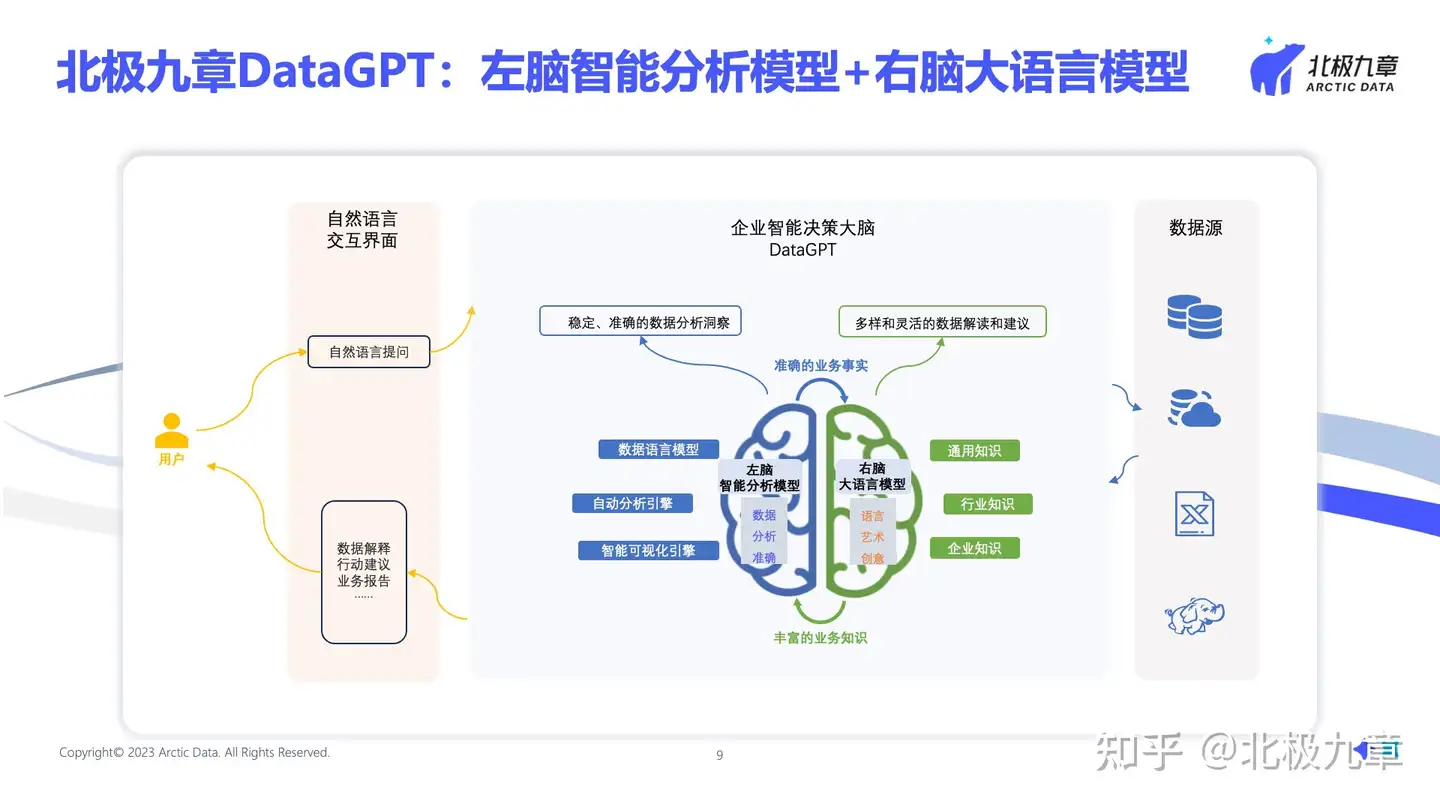

为了解决上文提到的四个问题,北极九章将自研的智能分析模型和第三方大语言模型结合起来,各展所长,将用户的一个简单问题转化为一系列洞察。

北极九章通过专门面向数据分析场景的数据语言模型,能够将用户的问题准确地转化为SQL语句,确保数据分析的准确性,再结合推荐算法、人工反馈校准,即使是小白用户也能问出更合适的问题。

此外,北极九章能够基于用户的一个“种子”问题,自动理解、补充、拓展多个相关的复杂问题,例如数据的趋势、异常、波动、成因等,并提炼出核心洞察、风险点等信息,用户即使没有分析思路也能一次性深入了解数据的全貌,快速锁定风险和机会。

借助大语言模型,北极九章能更好地处理丰富的语言表达,并给出多样灵活的数据解读和建议,在不损失准确性的前提下,基于通用知识和企业知识来进行报告撰写、辅助决策等,提升工作效率。